ICCV 2025 | Mitigating Object Hallucinations via Sentence-Level Early Intervention

Shangpin Peng*1, Senqiao Yang*2, Li Jiang3, Zhuotao Tian1✉️

1Harbin Institute of Technology, Shenzhen

2The Chinese University of Hong Kong

3The Chinese University of Hong Kong, Shenzhen

* Equal contribution

✉️ Corresponding author: tianzhuotao@hit.edu.cn

- [2025.07.30] 🔍 我们的工作被 52CV 解读,查看详情这里。

- [2025.07.21] 📖 所有代码、数据和模型已发布!

- [2025.06.26] 🎉 我们的 SENTINEL 被 ICCV 2025 接收!

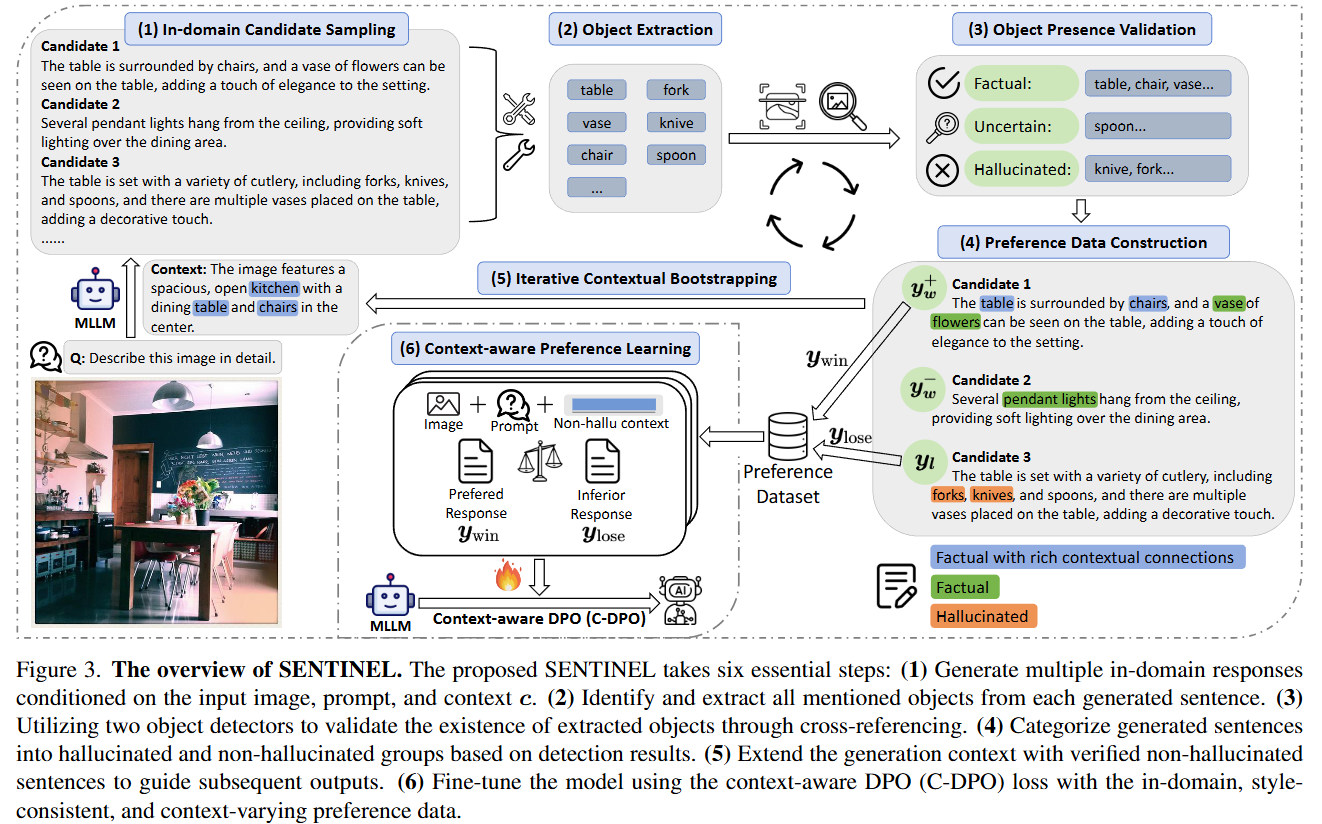

SENTINEL 引入了一种自动化、句子级别的早期干预策略,以防止和缓解多模态大语言模型(MLLM)中的对象幻觉。主要优势:

- 无需标注:不需要人工标注。

- 模型无关:兼容任何 MLLM 架构。

- 高效:轻量级 LoRA 微调。

🔑 主要特性

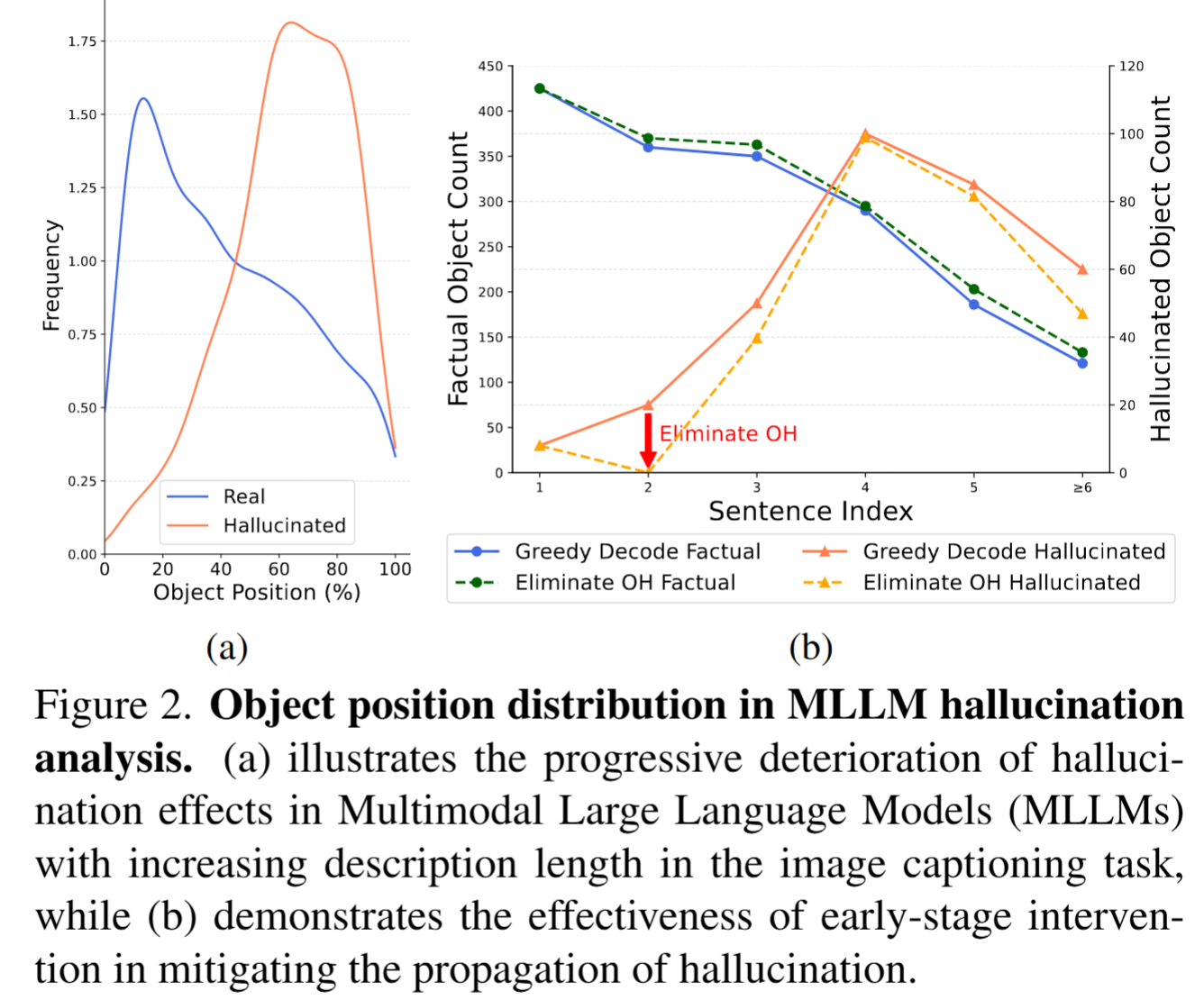

Section titled “🔑 主要特性”- 早期干预阻断幻觉传播。我们发现 MLLMs 的幻觉主要在前几句中产生,并在后续输出中不断传播。SENTINEL 提前打断该链条,以最大程度地缓解幻觉。

- 无需人工标注的域内上下文偏好学习。SENTINEL 通过检测器交叉验证构造幻觉/真实样本,并在不依赖专有 LLM 或手动标注的情况下构建域内偏好数据。

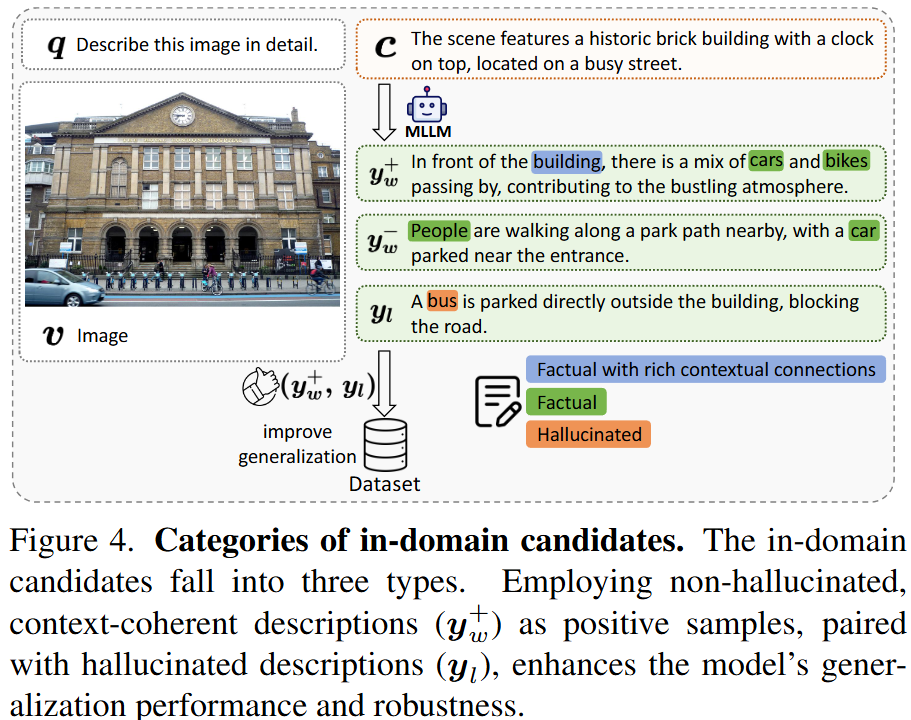

- 上下文至关重要:丰富的连贯性提升鲁棒性。通过优先选择上下文连贯的正样本,SENTINEL 显著提升了泛化能力。

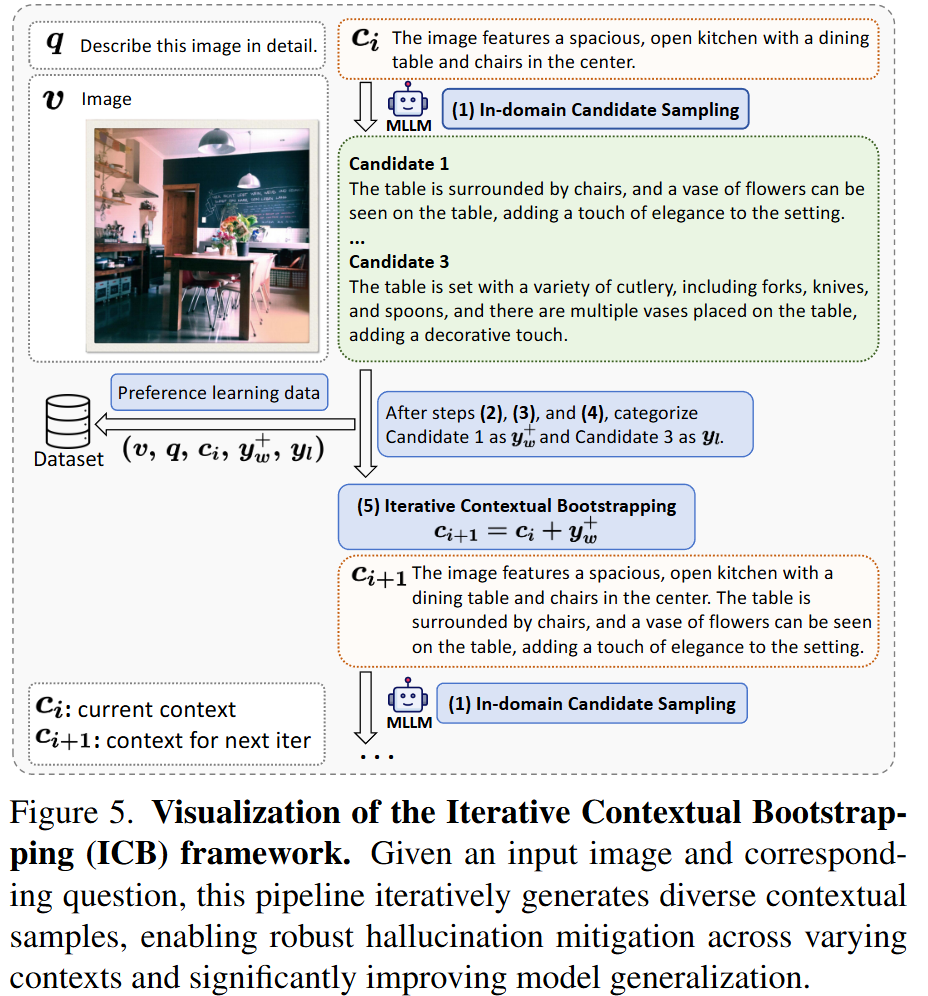

- 迭代式上下文自举,生成多样无幻觉上下文。我们的框架动态地扩展非幻觉上下文,覆盖更多场景,提升模型在推理阶段的鲁棒性。

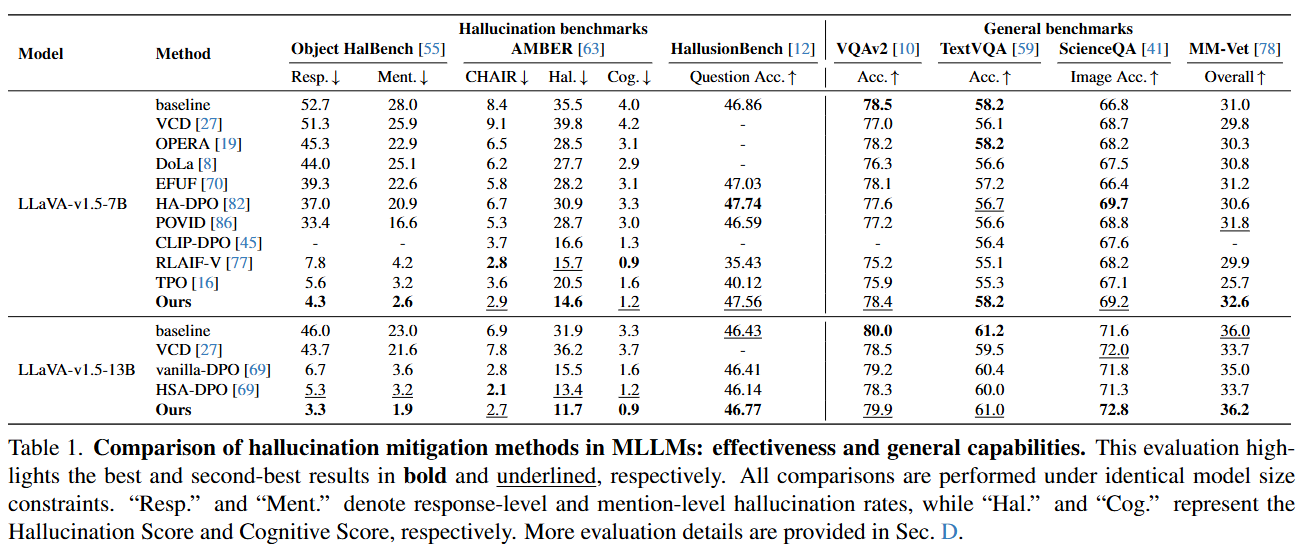

- 各基准测试中达到优秀水平。 SENTINEL 在减少幻觉方面最多可达 92% 的降低,并在 Object HalBench、AMBER 和 HallusionBench 上超越先前 SOTA 方法,同时保持或提升通用任务性能。

如果我们的模型/代码/数据/论文对您有帮助,请引用我们的论文并为我们点 ⭐️!

@inproceedings{peng2025mitigating, title={Mitigating object hallucinations via sentence-level early intervention}, author={Peng, Shangpin and Yang, Senqiao and Jiang, Li and Tian, Zhuotao}, booktitle={Proceedings of the IEEE/CVF International Conference on Computer Vision}, pages={635--646}, year={2025}}📧 联系我们

Section titled “📧 联系我们 ”如果您有任何问题、意见或建议,欢迎提交 issue 或 PR,共同推动该方向的研究进展。